28-річній американці на ім’я Кейт колеги показали відео, на якому вона займалася сексом із невідомим їй чоловіком. Ролик здавався більш ніж реальним, проте, переглядаючи його, жінка вперше побачила свого сексуального партнера, як і місце, у якому відбувалася зйомка. Після першого шоку Кейт зрозуміла, що на відео справді її обличчя, але тіло було зовсім не її. Історію цієї жінки та кількох інших описує американський проект HuffPost. Усі вони стали жертвами deepfake-порно — фальшивого відео, у якому їхні обличчя були додані до тіл порноактрис. Однак ці відеоролики мали таку високу якість і здавалися такими реалістичними, що навіть ті, чиї обличчя використали для створення підробок, не відразу розуміють, що стали жертвами фейку нового покоління.

Таке явище дістало назву deepfake. Це відеопідробки високої якості, порівняно з якими фейкові новини, відомі нині і школярам, і старшому поколінню, як дитячі каракулі порівняно з шедеврами живопису.

У чому небезпека

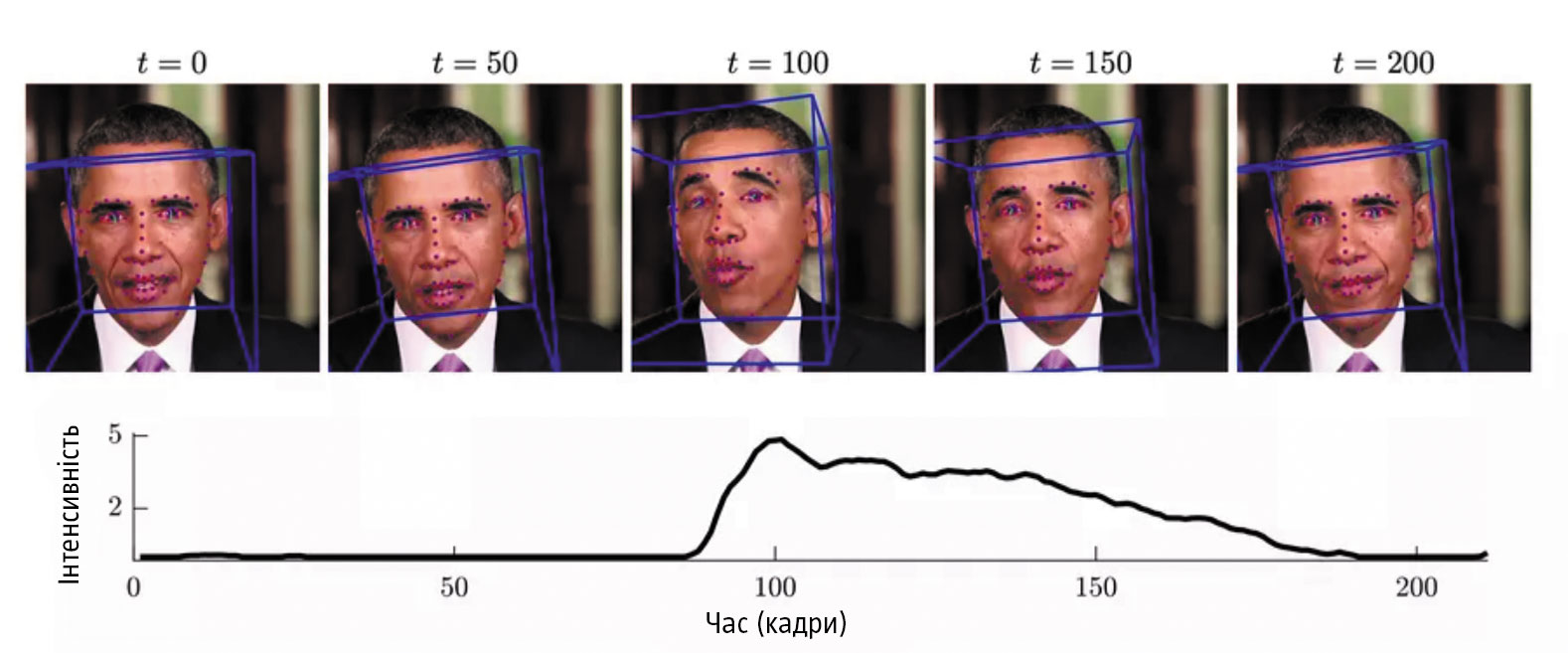

Термін deepfake означає «глибинна підробка» і виник від комбінації понять «глибинне навчання» (Deep learning) та «підробка» (Fake). Він описує набір технологій, які дають можливість накласти одні зображення та відео на інші. Їхня особливість та відмінність від усіх попередніх рукотворних фальшивок полягає у створенні такого відео, яке практично не можливо ідентифікувати як підробку. Окрім власне накладення обличчя на тіло іншої людини технології deepfake дають змогу, по-перше, сформувати потрібний звуковий ряд, і по-друге, продублювати артикуляцію та міміку іншої людини. У результаті поєднання цих інструментів у вуста жертви можна буквально вкласти потрібний авторам текст, тобто фактично «примусити» людину казати те, чого вона не казала, помістивши її в потрібний контекст. Перші deepfake-відео демонстрували таких відомих людей, як президенти Барак Обама та Дональд Трамп, керівник Facebook Марк Цукерберґ. Вони на цих відео повторювали за іншою людиною певний текст.

Читайте також: Апофенія

Елементи технології deepfake використовували в кіно. Найвідомішим і юридично легальним прикладом такої підробки можна назвати фільм «Бунтар один. Зоряні війни. Історія» (Rogue One: A Star Wars Story). Технології нейромереж і штучного інтелекту дали змогу використати в стрічці обличчя акторів Пітера Кушинґа та Керрі Фішер для персонажів Гранд-моффа Вілгуффа Таркіна та Леї Орґани. Хоча фізично їх зіграли Ґай Генрі та Інґвілд Дейла. Проте це чи не єдиний приклад використання елементів deepfake з благородною метою.

Людина з високорозвиненим критичним мисленням, яка знає про deepfake, може уважно придивитися до відео й помітити дуже дрібні деталі, майже не помітні неозброєним оком, що свідчать про підробку. Це або погано виставлене світло, або нерівномірність відео, або дивна міміка, або неточна артикуляція. Але ці нюанси можна знайти тільки тоді, якщо взяти під сумнів те, що показано на відео, і почати шукати в ньому дивні моменти. Проте якщо не задумуватися про факт підробки або дивитися таке відео з порівняно великої відстані, наприклад із 50 м, то його достовірність буде на найвищому рівні.

Демократизація штучного інтелекту

Для створення deepfake-відео використовуються інструменти роботи з нейромережами (один із різновидів штучного інтелекту). Перша нейромережа створює відеопідробку, друга відрізняє справжні відео від підробок. Ця технологія дістала назву GAN — генеративно-змагальна мережа (Generative adversarial network). Для роботи першої нейромережі потрібна велика кількість фотографій людини, яка є на відео. На їхній основі й створюється ролик. Друга нейромережа оцінює це відео на те, наскільки воно є підробкою. Якщо друга частина ідентифікує відео як фейк, то перша відкидає відео й більше не застосовує алгоритми та інструменти, використані для генерації невдалого фейку. Таким чином, дві нейромережі змагаються між собою у створенні якісної підробки.

Проте якщо кілька років тому використовувати ці інструменти могли лише професіонали й це потребувало потужних комп’ютерів, на яких ці нейронні мережі працювали б, то останнім часом склались ідеальні умови саме для масового використання GAN. По-перше, в інтернеті можна знайти безліч фотографій, зокрема знімків конкретної людини, які можна було б використати для створення deepfake. По-друге, у мережі з’явилися безплатні або недорогі інструменти роботи GAN. А по-третє, сучасні комп’ютери або недорогі хмарні середовища досить потужні. За їхньою допомогою будь-яка людина може генерувати роботу GAN. Тому деякі експерти називають deepfake прямим наслідком демократизації штучного інтелекту. А самі deepfake стали масовим явищем. Наприклад, на YouTube-каналі Ctrl Shift Face періодично публікуються deepfake-відео з різними відомими людьми.

Компанія Deeptrace, яка займається кібербезпекою, провела дослідження і виявила, що в грудні 2018 року в інтернеті було 7,9 тис. deepfake-відео, а в жовтні 2019-го їхня кількість збільшилася вдвічі, до 14,6 тис. Цікаво, що 96% цих відео порнографічного характеру.

Читайте також: Криза невідтворюваності

Сфера застосування

Влітку цього року в інтернеті з’явився мобільний додаток DeepNude (а потім і програми для Windows та Linux), який дає змогу в кілька кліків роздягнути жінок на фотографіях. За допомогою нейромереж можна видалити одяг зі знімків і домалювати частини тіла. На обробку одного фото потрібно до 30 с. У безплатній версії для ПК на знімку після обробки залишається логотип DeepNude, проте, купивши версію за $100, можна отримати чистий знімок без жодних поміток про те, що це фейк. Інтерес до технології DeepNude був таким, що сервери, із яких завантажувалися програми, кілька разів не витримували напливу охочих перевірити цей інструмент.

Через певний час автори сервісу DeepNude спочатку оголосили про його закриття, а згодом виставили його на продаж із початковою ціною $30 тис. Своє рішення вони пояснили тим, що не можуть гарантувати безпеку використання сервісу й хочуть знайти когось, хто готовий переробити алгоритм і знайти для нього інше застосування. Зараз оголошення про продаж у Twitter-акаунті сервісу немає, проте на сайті DeepNude вказано, що угода завершена. Навіть після видалення коду DeepNude та створених на його основі похідних інструментів у мережі можна було знайти і завантажити додатки, як вихідний, так і змінені.

На початку осені китайський інтернет буквально підірвав інший популярний deepfake-додаток Zao, який міг у будь-якому відеоролику замінити обличчя його героїв на надану фотографію. У такий спосіб можна вставити своє обличчя в будь-яке популярне відео чи у фрагмент фільму. Цей додаток активно обговорювався через один пункт його політики конфіденційності, у якому згадувалося, що автори програми можуть використовувати згенероване відео з власною метою. Розробники пояснювали, що ці відео потрібні їм для подальшого навчання нейромережі.

Брехня найвищого ґатунку

Сенатор Марко Рубіо називає deepfake-відео сучасним еквівалентом ядерної зброї. Він стверджує, що в наш час, щоб посіяти хаос, не потрібно витрачати кошти на озброєння, досить створити фальшиве відео, здатне як змінити результати виборів, так і буквально посіяти хаос у думках громадян.

Найімовірніше, першою реакцією пересічного користувача, який побачить, наприклад, як Барак Обама підтримує Ку-клус-клан чи як Олег Тягнибок щиро захоплюється Владіміром Путіним, буде шок, а не думка про необхідність перевірити достовірність цієї інформації. Такий фейк щодо відомої людини спростувати реально, хоча це й потребуватиме певного часу. Але якщо таке відео з’явиться напередодні виборів, то їхні результати можуть бути непрогнозованими. Крім того, deepfake-відео сексуального характеру здатні легко зруйнувати чийсь шлюб. Так само може постраждати ділова репутація або опинитися під загрозою важлива бізнес-угода, якщо, скажімо, показати зімітовані перемовини з конкурентами.

Читайте також: Гра в науку

Додатковим ризиком популяризації deepfake-відео є те, що платформи, які використовуються для їхнього поширення, не ідентифікують такі відеоролики. І навіть розуміючи, що це фейк, не завжди видаляють їх. У червні цього року в Instagram з’явилося deepfake-відео, героєм якого став Марк Цукерберґ, засновник та керівник Facebook. Відео було опубліковане з хештегом #deepfakes і з’явилося як експеримент двох дизайнерів, які ще зробили deepfake-ролики з Кім Кардаш’ян і Дональдом Трампом. При цьому адміністрація Instagram заявила, що не видалятиме відео, а от якщо фактчекери поскаржаться на них як на фейк, то компанія знизить їхню доступність, тобто вони не отримають багато уваги від аудиторії.

Попри те що новинна мережа CBS, логотип якої містить це відео, подала скаргу на несанкціоноване використання їхнього товарного знака, всі згадані вище ролики доступні в Instagram донині. Лише відео з Цукерберґом було переглянуте понад 115 тис. разів.

Сьогодні соціальні платформи тільки задумуються над тим, як вони боротимуться з deepfake. У липні цього року конгресмен Адам Шифф звернувся до Facebook, Twitter та Google з проханням надати пояснення щодо того, як вони планують боротися з deepfake-відео. Причиною звернення стала відмова Facebook видалити спотворене (навмисно сповільнене) відео, на якому Ненсі Пелосі, спікерка Палати представників, здається п’яною. Це відео з’явилося на Facebook-сторінці Politics WatchDog, і за три дні кількість його переглядів наблизилась до 3 млн, не менш активно поява цього відео та факт його спотворення обговорювались у медіа. Адміністрація YouTube оперативно видалила копії цього відеоролика, а ось Facebook відмовилася це зробити, повідомивши, що надіслала його на перевірку. Так само вчинили у Twitter. Згодом це відео у Facebook стала супроводжувати помітка про те, що воно, можливо, є фейковим.

На цей момент відео недоступне у Facebook. Проте тривале обговорення цієї історії породило багато запитань до політики соцмережі Facebook щодо фейкового контенту. У відповіді конгресмену Адаму Шиффу всі три платформи повідомили про те, що вони задумалися над вирішенням проблеми deepfake, проте наразі лише розробляють механізми протидії цій загрозі. Той факт, що deepfake-відео із самим Цукерберґом доступні в Instagram досі, може свідчити про те, що соціальні платформи ще не створили правил щодо deepfake-контенту. А без цього будь-яка боротьба проти нього буде дуже ускладнена.

Сізіфова праця

Водночас деякі соціальні сервіси (наприклад, Twitter та Reddit) заборонили використання deepfake. А розробники та великі компанії почали працювати над інструментами, які допоможуть ідентифікувати deepfake-відео. Наприклад, компанія Google оприлюднила базу даних із 3 тис. відео, які використовуються для створення deepfake-відео, і пропонує дослідникам використовувати їх для створення алгоритмів визначення фейків. На початку вересня цього року Facebook оголосила конкурс Deepfake Detection Challenge, у межах якого соцмережа проводить змагання на створення найефективнішого способу визначення deepfake-відео. Facebook готова витратити на ініціативу $10 млн, ця сума включає як призовий фонд, так і затрати на створення бази даних для навчання й тестування алгоритмів.

Утім, такий конкурс навіть у разі успіху дасть лише тимчасове рішення. Річ у тім, що є неприємна особливість фейкових deepfake-відео: покращення методів їхньої ідентифікації автоматично приводить до покращення технологій їхнього створення. У структурі алгоритмів GAN використовується принцип конкуренції: одна нейромережа (генератор) створює deepfake-відео, друга шукає підробку серед наданих їй відео (детектор). Тому будь-який метод, що покращує роботу детектора, використовується для вдосконалення роботи генератора, тобто інструменту створення відео. Це підтверджує професор Університету Південної Каліфорнії Хао Лі, автор алгоритму визначення deepfake, який може ідентифікувати відео у 97% випадків. Професор підкреслює, що його алгоритм, на жаль, є тимчасовим рішенням, як і будь-яке використання нейромереж для ідентифікації deepfake-відео. «Настане момент, коли неможливо буде виявити такі підробки. Для вирішення цієї проблеми доведеться застосувати інший підхід».

Стартап TruePic використовує блокчейн (систему збереження даних, яку неможливо змінити) для визначення маніпуляцій. Американське агентство перспективних дослідницьких проектів у сфері оборони (DAPRA) інвестує гроші в проект Medifor — інструмент аналізу відео та пошуку deepfake-роликів. Ідею використання блокчейну для збереження бази надійних джерел контенту й перевірки відео на достовірність узяли на озброєння ще кілька стартапів, які розробляють інструменти детекції deepfake. Автори стартапу Amber Authenticate теж розробляють систему ідентифікації на основі блокчейну, суть якої полягає в записі в загальнодоступний блокчейн цифрового зліпка відеоролика. Якщо відео змінити певними інструментами, то новий зліпок відрізнятиметься від оригіналу, що й буде сигналом про ймовірну підробку.

Ідея ще одного інструменту, який уже показала команда NYU Tandon, — створення спеціальних програм для «розумних» камер, які можуть додавати «цифрові водяні знаки» до відео. Ці помітки повинні підтвердити той факт, що відео було зняте на камеру, а не змонтоване й змінене deepfake-інструментами.

Встановити відповідальність

Якщо інтернету й соціальним платформам не вдасться вирішити проблему deepfake, то нам буквально доведеться не вірити тому, що ми бачимо та чуємо, а маніпуляції стануть звичним явищем у нашому житті. У найгіршому варіанті розвитку подій від нинішньої постправди (середовища, у якому емоціям і переконанням надається більше ваги, ніж фактам) ми прийдемо до умовного «кінця правди», коли поняття об’єктивної реальності просто зникне.

Читайте також: Харківські нейтрони, екзогалактичні планети та клоновані мавпи

Експерти зазначають, що deepfake не зникнуть як явище, вони ставатимуть дедалі винахідливішими й простішими в застосуванні. Наприклад, нещодавно з’явились інструменти, які дають змогу змінити людську мову у відео. Досить просто змінити текст стенограми, а інструмент уже відповідним чином попрацює над артикуляцією людини на відео, «примусивши» її говорити потрібний текст.

Окрім технічного рішення виходом можуть стати правові наслідки за застосування deepfake. Причому приклади такої категоричної боротьби з фейками вже є. Не секрет, що одним із найпопулярніших напрямів застосування deepfake-технології є створення порнографічного відео. Саме тому в американському штаті Вірджинія в законі про порнопомсту влітку цього року з’явилося положення про deepfake-відео. Таким чином, Вірджинія стала першим штатом, де є закон, що регулює використання deepfake. Його порушення загрожує тюремним строком до 12 місяців і штрафом до $2,5 тис.

Технологія deepfake перетворюється на одне з найбільших випробувань людства на критичне мислення та адекватність реакцій на такі виклики. Адже зброя, яку отримали автори deepfake-відео, надзвичайно потужна, силу й наслідки якої можна буде усвідомити тільки з часом.