Ще донедавна можливість омолодити актора без гриму, змінити його голос без студійного запису чи навіть створити цілковито віртуального персонажа здавалася науковою фантастикою. Сьогодні ж це реальність, яка стрімко змінює кіновиробництво. Нейромережі вже коригують акцент Едріана Броуді в «Бруталісті» й допомагають акторці з «Емілії Перес» у вокальних партіях, а 70 % гравців кіноринку впроваджують ШІ у виробничі процеси. Здається, межі можливого розширюються, але разом із цим загострюється дилема сучасного кіно: чи не стане людина зайвою у власному мистецтві? Чи збережеться унікальність живої гри, якщо замість актора працюватиме алгоритм? Де проходить тонка грань між інструментом і маніпуляцією? Про це — у нашому матеріалі про майбутнє кіноіндустрії.

Знімання фільму Емілія Перес. Фото Ville de Pantin

Пробудження машин: як технології заполонили кіно

Штучний інтелект швидко вийшов з експериментальної зони. Комп’ютерна система IBM Watson (керівник наукової групи — Девід Феруччі) 2016 року допомогла створити трейлер до фільму «Морган», аналізуючи емоційне забарвлення із сотень різних роликів. На початку 2020-х студії почали інтегрувати нейромережі не лише в скриптдевелопмент (розробку сценаріїв) чи аналітику (персоналізовані рекомендації), а й у виробничі процеси — від віртуальної зйомки до покадрової обробки візуальних ефектів (VFX) та фінального монтажу. Компанії A24, Disney, Universal, Lionsgate, Netflix — фактично всі важковаговики — напівофіційно чи відкрито користуються інструментарієм на основі штучного інтелекту.

Переваги очевидні: швидше створювати складні візуальні ефекти (зокрема, каскадерські епізоди), точно омолоджувати чи оживляти актора, інтегрувати його в інші сцени тощо. ШІ також дає змогу прогнозувати відгук публіки, тестувати альтернативні кульмінації та економити час (отже, і кошти) на певних рутинних процесах.

Одним із найгучніших технологічних експериментів в останні роки став деейджинг — цифрове омолодження актора. Ще на початку 2010-х Marvel і Disney за допомогою складних комп’ютерних маніпуляцій омолодили Роберта Дауні-молодшого у флешбеках «Першого месника». Та справжній прорив стався, коли Мартін Скорсезе в «Ірландці» (2019) використав цифрові ефекти, щоб повернути Аль Пачино й Роберта Де Ніро в їхні 40- й 50-річні образи. Але тоді команді з візуальних ефектів знадобилися місяці на покадрову корекцію.

Штучне омолодження Роберта де Ніро у фільмі Ірландець. Фото Netflix

Сьогодні ж процес значно спрощує ШІ. Технологія Metaphysic Live зчитує міміку актора й синхронно підмальовує риси обличчя. Саме вона допомогла омолодити Гаррісона Форда в п’ятій частині «Індіани Джонса» й стала в пригоді в новому фільмі Роберта Земекіса «Тут і зараз» для омолодження Тома Генкса й Робін Райт. Студія A24 уважно спостерігає за такими новинками та впроваджує пілотні рішення в процеси на етапі продакшну. Земекіс переносить концепцію колажу часу на екран: епохи накладаються одна на одну в межах єдиної локації. Завдяки FX-технології, що не потребує постпродакшну (Metaphysic Live) акторів омолоджують просто на знімальному майданчику.

Ставлення аудиторії до цих експериментів різне: хтось у захваті від того, що актор може повернутися до свого зоряного віку, інші нарікають на штучність і нереалістичність зображення. Цифрові обличчя потрапляють у так звану моторошну долину: людиноподібні об’єкти викликають відразу, якщо вони мають вигляд як люди й поводяться дуже схоже. Однак студії керуються фінансовим фактором. Ще кілька років тому деейджинг коштував десятки мільйонів доларів, нині ж інструменти на базі нейромереж здешевлюють процес уп’ятеро.

Український стартап змінює майбутнє кіно

Дві історії, що сколихнули Голлівуд і водночас підсилили дискусію довкола етики ШІ, — це фільми «Бруталіст» та «Емілія Перес». Історична драма «Бруталіст» здобула 10 номінацій на «Оскар» і 9 на «Бафту», а кримінальний мюзикл «Емілія Перес» — 13 та 11 відповідно. Стосовно «Бруталіста» медіа заговорили про штучно відшліфовану угорську мову Едріана Броуді й Фелісіті Джонс, які грають угорського архітектора Ласло Тота та його дружину Ержбет. Зі слів монтажера Давіда Янчо, спочатку намагалися використовувати автоматичну переозвучку (ADR), але в акторів залишалися неідеальні звуки й неправильні наголоси, що спантеличувало носіїв угорської. Зрештою залучили українську компанію — генеративний стартап Respeecher, який за допомогою ШІ-процесів змішав голос Янчо й голос акторів, щоб отримати ідеальну вимову. Так само й деякі візуальні фрагменти наприкінці «Бруталіста» створив генеративний ШІ, який допоміг відтворити уявні архітектурні проєкти головного героя.

Режисер «Емілії Перес» Жак Одіар теж скористався послугами Respeecher, щоб акторка Карла Софія Гаскон могла покращити вокальні партії. Продюсери зізналися, що це була швидша й дешевша альтернатива пошуку дублерів чи перезапису сцен. Перед цим ситуація загострилася під час голлівудських страйків 2023 року, коли актори й сценаристи виступили проти непрозорого використання ШІ. Одна з головних вимог Гільдії акторів США (SAG-AFTRA) — захистити права виконавців на власний образ і голос, адже студії прагнули дістати права на цифрові копії акторів без додаткової компенсації. Зрештою страйки змусили великі студії піти на поступки й укласти нові угоди, що регулюють використання ШІ. Проте питання комерційної вигоди залишилося відкритим: кіностудії отримали інструмент для зменшення витрат на виробництво, але ризикують утратити довіру аудиторії та професійних акторів.

Одне із зображень на підтримку страйків в Голлівуді у 2023 році. Зображення SAG-AFTRA

Представник студії A24 у коментарі для Тижня зауважив: «ШI — це потужний інструмент, але нам доведеться прописати прозорі правила, за яких умов дозволяти такі маніпуляції. Ми цікавимося всіма новими технологіями, які можуть розширити горизонти, проте усвідомлюємо етичні виклики й чекаємо чітких правил від гільдій».

Адвокати зі свого боку, апелюючи до випадку зі Скарлетт Йоганссон, нагадують: якщо ви записали свій голос чи знялися в певних сценах, то це ще не означає, що хтось має право змінювати чи використовувати ці матеріали в майбутніх проєктах без згоди. Йдеться про випадок, коли OpenAI без дозволу Йоганссон створила голос, схожий до голосу акторки, і використала його в рекламному ролику ChatGPT-4o. Це викликало хвилю обговорень про цифрові права акторів. Відтоді юристи активно розробляють механізми захисту, а студії шукають проміжне рішення: чи варто кожну зміну узгоджувати з актором? Аналогічні запитання виникають також із цифровим мейкапом, де можна підтягнути фізичний вигляд аж до невпізнаваності, що ставить нові етичні й правові дилеми перед індустрією.

Межа між інструментом і маніпуляцією

Компанія Cinelytic надає режисерам і продюсерам аналітичні інструменти для оцінки сценаріїв: алгоритми вивчають закономірності успішних кіноісторій та пропонують зміни, які, з погляду великих даних, підвищують привабливість проєкту для масової аудиторії. Vault AI виконує схожі функції, прогнозуючи ефективність окремих сюжетних ліній залежно від вікової та демографічної аудиторії. Водночас на ринку з’являються ChatGPT-подібні моделі, здатні генерувати повноцінні сценарні чернетки. Однак поки що ці алгоритми демонструють обмежені можливості щодо психологічної глибини персонажів і природності діалогів.

Використання технології захоплення руху в Аватарі

Викликом для індустрії стає генеративне відео — так звані text-to-video системи (Runway, Kaiber, Pika Labs), які на основі короткої текстової підказки (промпту) і зображень-семплів здатні створювати нові сцени, задні плани, оточення. Наразі їхня якість обмежена короткими роликами й 15–30-секундними фрагментами, що не забезпечують реалістичного відтворення облич та складних рухів. Проте покадрова стабільність і роздільна здатність постійно вдосконалюються, відкриваючи можливості для покоління переконливих кадрів, які можна використовувати як b-roll (відеокадри, які накладаються на основне відео), вставні сцени або навіть повноцінні аніматики.

Для сценаристів і режисерів це означає, що вони можуть створювати візуальні концепти сцен без значних фінансових витрат і завдяки цьому спростити процес презентації ідей продюсерам та акторам. Якщо врахувати стрімкий розвиток text-to-image технологій (Midjourney, DALL-E) за останні півтора року, можна очікувати, що протягом наступних 2–3 років text-to-video здійснить подібний технологічний прорив, змінюючи принципи виробництва відеоконтенту.

За словами Девіда Кавана, який до 2024 року був виконавчим директором Федерації сценаристів Європи, найближчим часом під ризиком опиняться повторювані жанри, зокрема дитячий контент і серіали — мильні опери, де сюжетні формули передбачувані й легко відтворювані. Водночас у сфері складної драматургії штучний інтелект ще довго не зможе перевершити живу уяву людини.

Аналогічні дискусії точилися сто років тому із появою звукового кіно, коли чимало зірок німого екрана втратили кар’єру, або пізніше із запровадженням кольорового зображення, що спочатку здавалося знеціненням чистої естетики чорно-білого кадру. Проте випадок зі штучним інтелектом принципово відрізняється: уперше машина намагається відтворити людську креативність на всіх рівнях — від драматургії до емоційної гри.

Юридичні аспекти й голос індустрії

Головний виклик для студій полягає в тому, що немає чітких регуляторних норм. Чи має актор бути повноправним власником своїх цифрових копій? Чи може компанія OpenAI (або будь-яка інша, що створила штучний голос) зберігати голосові зразки й продавати їх третім сторонам? А що відбувається у випадку, якщо за допомогою нейромережі створили роль актора, який відмовився брати участь у проєкті?

У США після масових страйків WGA та SAG-AFTRA 2023 року розпочались активні переговори між профспілками й студіями про запровадження етичних стандартів використання ШІ в кіноіндустрії. Основні вимоги включають збереження контролю актора над його зовнішністю й голосом, прозорість методів створення цифрових двійників, а також чітку систему компенсацій, якщо такий ШІ-образ приносить прибуток.

Режисери не мають єдиної позиції щодо ШІ. Наприклад, Девід Фінчер («Соціальна мережа», «Бійцівський клуб») залишається скептиком, вважаючи, що технологія поки що «не здатна передати справжню емоційну глибину». Водночас Роберт Земекіс наголошує, що без ШІ-інструментів деейджинг у фільмі «Тут і зараз» був би неможливий. Незалежні кінематографісти, які не мають великих бюджетів, розглядають ці технології як інструмент демократизації кіновиробництва, що зменшує фінансові ризики й вирівнює можливості між голлівудськими студіями та меншими продакшнами.

Робота над фільомом Тут і зараз з використанням технології Metaphysic Live. Фото Metaphysic

Головний конфлікт довкола ШІ полягає в загрозі скорочення сотень професій — від сценаристів, операторів і монтажерів до аніматорів, гримерів, каскадерів і костюмерів. Проте ці фахівці не просто витратний матеріал кіноіндустрії, а жива спільнота професіоналів, які формують унікальний кінематографічний простір.

Аналітичні компанії, зокрема Deloitte Insights та McKinsey, прогнозують, що протягом найближчих 3–5 років автоматизація виробничих процесів і поширення генеративних нейромереж можуть знизити собівартість кіновиробництва на 20–30 %. Це стосується передусім монтажу, кольорокорекції, 3D-превізу, CGI-сцен середньої складності й дубляжу. Водночас стартапи, що пропонують text-to-video технології, залучають рекордні інвестиції.

Великі студії на кшталт Disney, Warner Bros., Netflix уже створюють ШI-відділи, тестуючи генеративні алгоритми в локалізації, трейлерах і фонових персонажах. Netflix нещодавно профінансував розробку аніме-серіалу, створеного майже повністю нейромережею, а Disney використовує ШІ для оптимізації маркетингових кампаній. Проте незалежні команди, які працюють в AI-first середовищі, часто випереджають гігантів: їм простіше експериментувати, не оглядаючись на юридичні й етичні зобов’язання. Швидкої тотальної революції не буде: студії рухатимуться через компроміси. Спершу нейромережі застосовуватимуть для допоміжних завдань (наприклад, покращення діалогів чи дубляжу), а вже потім — для створення цифрових акторів і дипфейк-сцен.

Віртуальні актори, цифрові гримери й промпт-сценаристи — хто працюватиме в кіно завтра

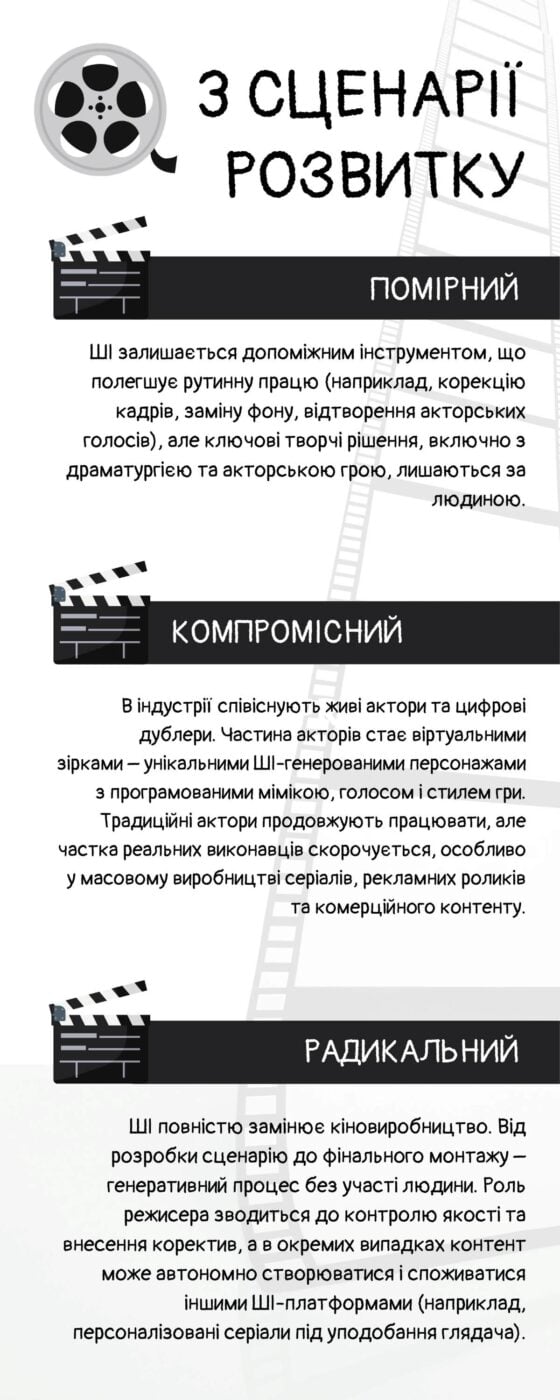

3 сценарії розвитку ШІ в кінематографі

Як показує історія кінематографа, кожен технологічний прорив не лише витісняв частину професій, а й створював нові. Наприклад, із впровадженням технології захоплення руху (mo-cap) з’явилася професія актора-аніматора, а костюмери й гримери почали працювати із цифровими моделями. Сучасні CGI-технології змінили роботу декораторів, операторів, постановників сцен, а перехід до VR та AR-кіно створив спеціальність імерсивного режисера.

В епоху, коли кіноіндустрія стає керованою ШІ (AI-driven), неминуче виникнуть нові професії. Серед можливих — гід (дизайнер) ШІ-двійника, координатор цифрового макіяжу, промпт-сценарист, цифровий гример, інженер синтетичних голосів, візуалізатор сцен, ШІ-супервайзер, редактор трейлерів на базі ШІ, спеціаліст з нейромережевого захоплення руху. Це означає, що професії в кіно не зникнуть, а трансформуються, створюючи новий баланс між людиною та алгоритмами.

Попри технологічний прорив, повна заміна акторів і живих знімань навряд чи відбудеться миттєво. Людська міміка, індивідуальна пластика й тонкі емоційні нюанси все ще складно відтворити так, щоб глядач не відчув ефект синтетичності. Водночас приклад франшизи «Аватар» Джеймса Кемерона, де більшість екранного часу займає комп’ютерна графіка, свідчить: аудиторія готова приймати цифрову реальність, якщо сюжет і персонажі викликають емоційний відгук. «Аватар 3» вийде на екрани 2025 року, «Аватар 4» — 2029-го, а «Аватар 5» — 2031-го.

Сьогодні найімовірнішим є сценарій поєднання людської творчості з можливостями ШІ. Кінокомпанії поступово скорочують витрати на реальні декорації, масовку, традиційні візуальні ефекти, натомість збільшують інвестиції в алгоритми, що дають змогу швидше та дешевше створювати контент. Однак мистецьке бачення завжди було й буде прерогативою людини.